(著)山たー

CourseraのComputational Neuroscienceの1週目。読む上での注意点はWeek0を参照してください。

計算論的神経科学の概要と、受容野の話を例にとった計算論的モデルの説明。および、基本的な神経生理学。

1.1: Course Introduction

このコースで学ぶことは主に3つ。

脳の記述モデル(Descriptive Models of the Brain)

●ニューロンはどのように外部刺激に反応するか

●外部刺激への反応をニューラルエンコーディングモデル(neural encoding model)で定量的にどのように記述するか

●どのようにしてニューロンから情報を抽出することができるか(デコーディング(decoding))

脳細胞とネットワークのメカニズムモデル(Mechanistic Models of Brain Cells and Networks)

●どのようにして、コンピュータ上において単一のニューロンの動作をシミュレートできるか。

●どのようにして、ニューロンのネットワークをシミュレートするか。

脳の解釈モデル(Interpretive (or Normative) Models of the Brain)

●なぜ脳の神経回路はそのやり方で動作するか

●神経回路の計算操作の基礎となる計算原理は何か

計算論を用いて脳を理解するとは、

①脳のモデルを記述すること → encoding modelとdecoding model

②脳細胞やネットワークの力学的モデルの構築 → ニューロンを計算機上でシミュレーション

③脳のモデルの解釈 → ニューロンやネットワークのダイナミクスを理解

の3つを行うことである。

1.2: Descriptive Models

計算論的神経科学とは何か

計算論的神経科学の目標は、脳がどのようにして行動を生み出すかを計算論的用語を用いて説明すること(The goal of computational neuroscience is to explain in computational terms how brains generate behaviors)。(Terry Sejnowski)

「神経系が何をするのか(what)を特定し、それらがどのように機能しているのか(how)を特定し、なぜそれらが特定の方法で動作するのか(why)を理解する」手段や方法を計算論的神経科学は提供する。(P. Dayan and L. Abbott)

根本的な計算論的モデルとしては次の3つ。

1. Descriptive Models ("what")

2. Mechanistic Models ("How")

3. Interpretive Models ("Why")

例:受容野のモデル

受容野(receptive field)を例にとって3つのモデルを考える。

HubelとWieselは1965年に猫に視覚刺激を行った時の脳内のニューロンの活動を調べた。

実験の様子はYoutubeで見ることができる。

電極をスピーカーに繋ぎ、ニューロンが発火したときに「バチバチ」という音が聞こえるようになっている。これは斜めの線に対して特異的に反応するニューロンの発見である。

特定の方位に対してのみ、多くのスパイクが生じる(次図)。

受容野とは何か

特定の刺激に応答する末梢感覚神経の領域。刺激ごとに異なる受容野を持つ。

I. Descriptive Model of Receptive Fields

Whatについての疑問:

●何によって、方位選択的な発火が生じているのか

まず、光刺激は網膜(retina)の網膜神経節細胞(retinal ganglion cell; RGC)が受容する(図左)。RGCの受容野は中心-周辺型の構造であり、光刺激に対して、照射されたときに発火する部分(On領域)と光がなくなったときに発火する部分(Off領域)が存在する(図右)。白い部分がOn領域、灰色の部分がOff領域となっている。

RGCの受容野には、On中心-Off周辺型とOff中心-On周辺型の2種類存在する。

次に、情報は

網膜(Retina) → 外側膝状体(LGN) → 一次視覚野(V1)

という経路で、最終的にV1に情報が投射される。

V1には方位選択的な受容野が存在する。そのため、V1の一部のニューロンの膜電位を記録すると、ある方位に対してのみ、多数のスパイクが記録される。

※後の講義で逆相関法 (reverse Correlation)を用いて、受容野を定量化する方法を説明する。

1.3: Mechanistic and Interpretive Models

II. Mechanistic Model of Receptive Fields

Howについての疑問:

●受容野は視覚野の神経回路を用いて、どのように構築されているのか。

●中心-周辺(center-surround)構造を持つ受容野から、方向づけられた(oriented)受容野はどのようにして得られるか。

まず、刺激情報は網膜の細胞から外側膝状体(LGN)へ、続いて一次視覚野(V1)へ投射される。

HubelとWieselは1960年代に「V1の受容野はLGNの入力を統合して作られている」というモデルを提唱した。このモデルでは、中心-周辺構造を持つLGNの受容野が数個集まって、直線状に配列することで方位選択的なV1の受容野ができていると説明される。

この単純なモデルはまだ議論の余地がある。

III. Interpretive Model of Receptive Fields

Whyについての疑問:

●なぜV1の受容野はこのように形作られているのか。

効率的コーディング仮説:

受容野$RF_1, RF_2,\cdots$などを持つニューロンを使用し、可能な限り忠実かつ効率的に画像を表現することが目的であるとする仮説

次図のような自然画像から受容野$RF_i$を学習し、効率よく画像を再構成するアルゴリズムとして、スパース符号化(Sparse coding)、独立成分分析(ICA)、 予測符号化(Predictive coding)がある。

画像の再構成について、スパース符号化は(Olshausen & Field, 1996)、独立成分分析は(Bell & Sejnowski, 1997)、予測符号化は(Rao & Ballard, 1999)による論文がある。

以下はPredictive Codingによる結果。

Rao, Rajesh & H. Ballard, Dana. (1999). Predictive Coding in the Visual Cortex: a Functional Interpretation of Some Extra-classical Receptive-field Effects. Nature neuroscience. 2. 79-87. 10.1038/4580 (Research Gate)

得られた受容野は次のようになる。

この方位選択的なフィルタ(Gaborフィルタ)はV1のものに似ている。

結論:脳は、外部環境を忠実かつ効率的に表現しようとしている(可能性がある)

※この辺りはNeural Networkによる視覚野の再現と関連する。NNによる受容野はよりはっきりしているが、NNを用いなくても、このような受容野が再現できる。

1.4: The Electrical Personality of Neurons

脳とニューロン

脳の領域によって様子は異なるが、全て神経細胞(ニューロンとグリア)から成り立っている。

ニューロンの構造

左から樹状突起(dendrites)、細胞体(cell body)、軸索(axon)、ランビエ絞輪(node of Ranvier)、ミエリン(myelin)、シナプス前終末(presynaptic terminal)。入力は他のニューロンの軸索から受け、シナプス前終末から出力を行う。

活動電位

近接するニューロンからの入力が閾値を超えるとスパイク(出力)の発火が起きる。制御にはイオンチャネルが関わっている。

1.5: Making Connections: Synapses

電気シナプスと化学シナプス

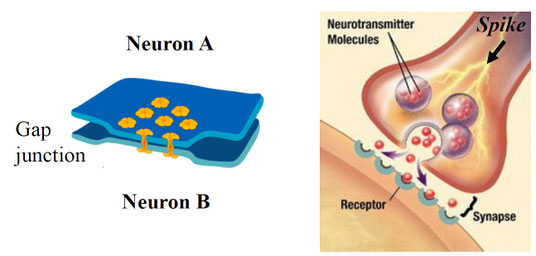

ニューロンとニューロンはシナプスと呼ばれる構造によって繋がっている。シナプスには電気シナプスと化学シナプスの2種類ある。ヒトの中枢神経系ではほとんどが化学シナプスだが、それでは化学シナプスは何故勝利したのだろうか。

まず、2つを比べてみる。電気シナプス(electrical synapse)はギャップ結合(gap junctions)による結合であり、ニューロンから次のニューロンへイオンチャネルを用いてシナプス伝達を行う。情報伝達速度は極めて速い(<0.1msec)。代表的な例として、ザリガニが外敵から素早く逃げるために電気シナプスを用いている。一般には無脊椎動物に多く見られるが、下オリーブ核などヒトの中枢神経系にも存在している。

次に、化学シナプス(chemical synapse)はシナプス前膜と後膜の間にシナプス間隙が存在する。要は直接くっ付いてはいない。シナプス前細胞は神経伝達物質(neurotransmitter)をシナプス間隙に放出し、次のニューロンに受容させる。伝達物質が受容体に結合すると、イオンがシナプス後細胞に流入し、膜電位が変化することでシナプス伝達が行われる。情報伝達には2-3msecかかり、これをシナプス遅延という。

次図は2種類のシナプスの模式図。左が電気シナプス、右が化学シナプスの様子。

電気シナプスは直接イオンを次のニューロンに送る。それに対し、化学シナプスは神経伝達物質を放出し、それを受容体で受容させてからイオンを次のニューロンに流入させている。ステップが1つ余計に増えているわけであり、必要とする構造も増える。

遅いし、複雑なので、化学シナプスは劣っているように思えるが、実際は逆。化学シナプスには電気シナプスにない利点があり、そのために化学シナプスの方がより多く用いられている。

まず、電気シナプスは抑制することができない。そのまま情報(電気的興奮)を伝達するだけである。そのため、学習ができない(学習に役立つこととは別)。一方で、化学シナプスは神経伝達物質を用いているため、抑制が可能である。神経伝達物質を複数種類用いることで、情報を伝達する次のニューロンを選択できる。ちなみに神経伝達物質は100種類以上確認されている。

電気シナプスは高速に情報伝達するというより、神経細胞を周期的に同期活動させるために用いられているといった方が良い。別の例で言えば、電気シナプスではないが、心筋はギャップ結合を用いることで、同期して拍動することができている。もし、バラバラに動いたらポンプとしての機能を失ってしまう。

化学シナプスの修飾

化学シナプスはどうやってニューロン間の結合の強さ(Neural Networkでいうところの重み(weight))を変更しているのだろうか。その答えとして、シナプス修飾がある。シナプス伝達の効率は、シナプスが修飾されることで柔軟に変化する。シナプス修飾にはシナプス前修飾とシナプス後修飾の2種類ある。

シナプス前修飾はシナプス前細胞において、伝達物質の放出効率(放出確率や放出部位数)を調節することである。シナプス後修飾はシナプス後細胞のイオンチャネル型受容体の伝達物質の感度を調節することである。

EPSPとIPSP

シナプス伝達をした結果、シナプス後細胞において、興奮性または抑制性の膜電位変化が生じる。それぞれEPSP(Excitatory Post-Synaptic Potential; 興奮性シナプス後電位), IPSP(Inhibitory Post-Synaptic Potential; 抑制性シナプス後電位)という。

EPSPは非選択的な陽イオンチャネル型受容体(受容する物質はアセチルコリンやグルタミン酸など)が陽イオンを通すことによって生じ、IPSPはCl-(クロライドイオン)を透過するイオンチャネル型受容体(受容する物質はGABAやグリシンなど)がCl-を通すことによって生じる。

EPSPは後細胞の膜電位を上げ、IPSPは膜電位を下げる。複数のシナプス前細胞から生じたEPSPとIPSPを加重(summation)した結果、閾値を超えるとシナプス後細胞は発火する。

加重には時間的加重(temporal summation)と空間的加重(spatial summation)がある。単一のニューロンにより短時間に複数のEPSP(IPSP)が生じることで閾値を超えて発火するのが時間的加重。複数のニューロンにより複数のEPSP(IPSP)が生じることで閾値を超えて発火するのが空間的加重。

要は1つのニューロンだろうが、複数のニューロンだろうが、短時間に複数のEPSPが生じることで発火する。IPSPが生じたら、それを打ち消すだけのEPSPが生じなければ発火は起こらない。

シナプス可塑性

シナプスは記憶と学習の基礎である。それらを生み出しているのがシナプスの可塑性(synaptic plasticity)である。シナプスの修飾により、各ニューロン間の情報の伝達効率が変化するが、これは学習則に従って修正を受ける。

有名な学習則としてHebb則がある。これは心理学者のDonald Hebbが1949年に発表した学習則で、『ニューロンAの発火がニューロンBの発火に繰り返し関与した場合、AからBへの情報伝達の強度と速度が高められる』というものである。

Hebb則は長期増強(Long-Term Potentiation; LTP)と長期抑圧(Long-Term Depression; LTD)という実験的現象の発見により注目された。

長期増強(LTP)とは高頻度刺激により、EPSPのサイズが持続的(数時間~数日)に増加する現象である。

長期抑圧(LTD)とは低頻度刺激により、EPSPのサイズが持続的(数時間~数日)に減少する現象である。

これらの現象は何によって決まっているのだろうか。実はシナプス可塑性(Synaptic Plasticity)はスパイクの頻度というより、タイミングに依存している。つまり、LTPとLTDは入力と出力のスパイクのタイミングに依存して生じる。

ニューロンAの発火とニューロンBの発火のタイミングを計測したとき、Aの発火がBの発火の前に起こった場合にLTPが生じ、Aの発火がBの発火の後に起こった場合にLTDが生じることが分かる。

この法則をスパイクタイミング依存性可塑性(Spike-Timing Dependent Plasticity; STDP)という。略してSTDP則と呼ばれることが多い。

※STDP則は次のように説明できる。

●長期増強(LTP):

シナプス後のニューロンが発火する前に入力が起こったということは、その入力は後のニューロンが発火するために必要であったということである。ゆえに必要な入力として扱われ、増強が起こる。

●長期抑圧(LTD):

シナプス後のニューロンが発火した後に入力が起こったということは、その入力が無くてもシナプス後のニューロンは発火したということである。ゆえに必要のない入力として扱われ、抑圧が起こる。

要は入力をスパース化しているわけである。学習時に正則化をかけているとも言える。単純だが強力な学習則である。また、STDP則を簡略化したのがHebb則とも言え、2つの法則の主張は一致する。

※シナプス可塑性は持続時間が様々である。持続時間が短い順に

●促通 (facilitation)

●抑圧 (depression)

●増強 (augmentation)

●テタヌス後増強 (post-tetanic potentiation; PTP)

●長期増強 (long term potentiation; LTP)

●長期抑圧 (long term depression; LTD)

といった現象がある。

Spiking Neural Network

Neural Networkの学習には誤差逆伝搬法が用いられるが、実際の脳において誤差逆伝搬法で学習している部分はごく少数しかない。多くがこのSTDP則により学習している。今のNeural Networkの主流は生理的妥当性を考えずに発展しているが、Spiking Neural Network (SNN)というスパイクを考慮したNeural Networkが考案されている。SNNは誤差逆伝搬法ではなく、STDP則により学習を行っている。SNNの研究は現在、活発に行われており、例を挙げれば、

●STDP-based spiking deep convolutional neural networks for object recognition

●Deep Learning in Spiking Neural Networks

など。

SNNの解説は

●Spiking Neural Networks, the Next Generation of Machine Learning

など。

「脳波も再現できる」とはいうものの、現状では深層の学習が難しい。しかし、ANN(artificial neural network; 人工神経回路)の内部とヒトの脳活動との整合性が取りづらい。深層SNNとヒトの神経活動が一致することで、モデルの妥当性が示せるようになるのでは、と思っている。

1.6: Time to Network: Brain Areas and their Function

末梢神経系と中枢神経系

神経系は末梢神経系と中枢神経系に大別できる。

末梢神経系(Peripheral Nervous System;PNS)は骨格筋の制御と体性感覚の処理を行い、主に体性神経系と自律神経系に分けられる。中枢神経系(Central Nervous System;CNS)は脳と脊髄に分けられる。

末梢神経系

末梢神経線維には求心性神経線維(Afferent Nerve Fibers)と遠心性神経線維(Efferent Nerve Fibers)がある。

求心性神経線維はincomingなもので、末梢からPNSへ情報を伝達する。感覚神経は求心性。

遠心性神経線維はoutgoingなもので、PNSから末梢へ情報を伝達する。運動神経は遠心性。

中枢神経系

中枢神経系(Central Nervous System;CNS)は脊髄(Spinal Cord)と脳から成り立つ。

〇脊髄

・Local feedback loopsが反射を制御している。

・脳からの下行性運動制御信号(Descending motor control signals)は脊髄運動ニューロンを活性化する。

・上行性感覚軸索(Ascending sensory axons)は筋肉や皮膚からの感覚情報を脳へ伝える。

〇脳

(1)菱脳(hindbrain)

菱脳=延髄(medulla oblongata)+ 橋(pons)+小脳(cerebellum)

●延髄:呼吸、筋肉の収縮および血圧を制御する

●橋:小脳と繋がっており、睡眠と覚醒に関与

●小脳:随意運動の調節、平衡感覚など

(2)中脳(midbrain)と網様体(reticular formation)

●中脳:眼球運動、視覚と聴覚の反射

●網様体:筋反射、呼吸および痛みの知覚を調整する。 また、睡眠と覚醒を調節する。

(3)視床(thalamus)と視床下部(hypothalamus)

●視床:皮質への(においを除く)全ての感覚情報の「中継局」。また、睡眠と覚醒を調節する。

●視床下部:基本的な欲求(戦闘、逃走、食欲、性欲)を調整する。

(4) 大脳(cerebrum)

大脳は大脳皮質(cerebral cortex)、大脳基底核(basal ganglia)、海馬(hippocampus)、扁桃体(amygdala)から成る。

●大脳皮質(cerebral cortex):

ニューロンシートの層(おおよそ300億のニューロン)から成る。 各ニューロンは約10,000のシナプスを形成し、結合の総数は約300兆にもなる。

大脳皮質の層は6つある。1層は分子層、2層は外顆粒層、3層は外錐体細胞層、4層は内顆粒層、5層は内錐体細胞層、6層は多形細胞層と名前が付いている。機能的には次のようになっている。

1:皮質内の深い層(5, 6層)からの入力

2+3:皮質内の深い層(5, 6層)への出力

4:入力(主に感覚入力。一次感覚野で顕著)

5:皮質下構造への出力(この層の巨大錐体細胞が皮質の主な出力経路)

6:皮質下構造への出力(入力元へのフィードバック層)

※細かいところは皮質領野間で異なる。また「出力」ではなく「投射」という言葉の方がよく使われる。

神経 vs コンピュータ

●デバイス数:

・人間の脳:1011個のニューロン(各ニューロンは最大で104もの接続をしている)

・シリコンチップ:疎(sparse)に結合している1010個のトランジスタ

●デバイスの速度:

・生物は100μsの時間分解能を有する

・デジタル回路は100psクロック(10GHz)に近づいている

●計算のパラダイム:

・脳:超並列計算素子間が適応的に接続される

・コンピュータ:素子間の接続が固定された、CPUによる逐次情報処理

※最近は並列計算アルゴリズムが発達し、GPUを用いることで並列に情報処理できるようになってきてはいる。

●機能:

・コンピュータ:数学と記号の処理に優れている

・脳:会話や言語処理、視覚情報の処理などの不良設定問題(ill-posed problem)を解決することに優れている

※不良設定問題とは解くための情報が少ない問題のこと。脳は経験を用いて情報を補うことで、不良設定問題を解いている。

部分的には脳とコンピュータは近いが、違う部分も多い。同じ認識で考えていると脳の理解は深まらない。また、脳の計算理論は未だ未知であり、理解には数理的なモデルを構築する必要がある。

Week1の略語・重要語一覧

CNS:Central Nervous System (中枢神経系)

PNS: Peripheral Nervous System (末梢神経系)

V1: Primary Visual Cortex (一次視覚野)

LGN: Lateral Geniculate Nucleus (外側膝状体)

RF: Receptive Field (受容野)

GABA:神経伝達物質の一種のγ-アミノ酪酸(gamma-aminobutyric acid; C4H9NO2),

GABAB: K+チャネルを開く/閉じるためにGタンパク質中間体を用いているメタボトロピック受容体

EPSP:Excitatory Post-Synaptic Potential(興奮性シナプス後電位)

IPSP: Inhibitory Post-Synaptic Potential (抑制性シナプス後電位)

LTD: Long-Term Depression (長期抑圧)

LTP: Long-Term Potentiation (長期増強)

STDP: Spike-Timing Dependent Plasticity (スパイクタイミング依存性可塑性)

CPU:Central Processing Unit(中央演算処理装置)

ICA: Independent Component Analysis (独立成分分析)

Programming-Quiz

PythonとMatlabのそれぞれについての問題。「あ、その書き方でもOKなんだ」という内容が多かった。なので案外、間違えた。

コメントをお書きください